Con l'uscita di ChatGPT il mondo dei modelli di intelligenza artificiale è esploso creando un sempre più crescente interesse su di essi, in particolare sui Large Language Model (LLMs) sia da parte degli sviluppatori sia da parte di chi crea questi modelli. Questi per potere essere eseguiti sfruttano grosse macchine virtuali che dispongono di GPU dalle grandi capacità di memoria per poterli contenere. OpenAI è stata tra i primi a mettere a disposizione questi modelli con un approccio basato a servizio e a consumo attraverso API REST che rendono molto facile il suo utilizzo, senza preoccuparci dell'infrastruttura.

In Microsoft Azure, una sezione OpenAI è stata inserita, grazie alla partnership, per consentirci di sfruttare i modelli GPT con lo stesso approccio integrandoci con tutto l'ecosistema della piattaforma, come i permessi, le virtual network e un billing unificato. Grazie all'esplosione dei modelli, però, questa esigenza si è allargata non solo per quelli offerti da OpenAI, ma anche per sfruttarne degli altri, più verticali, open source o meno.

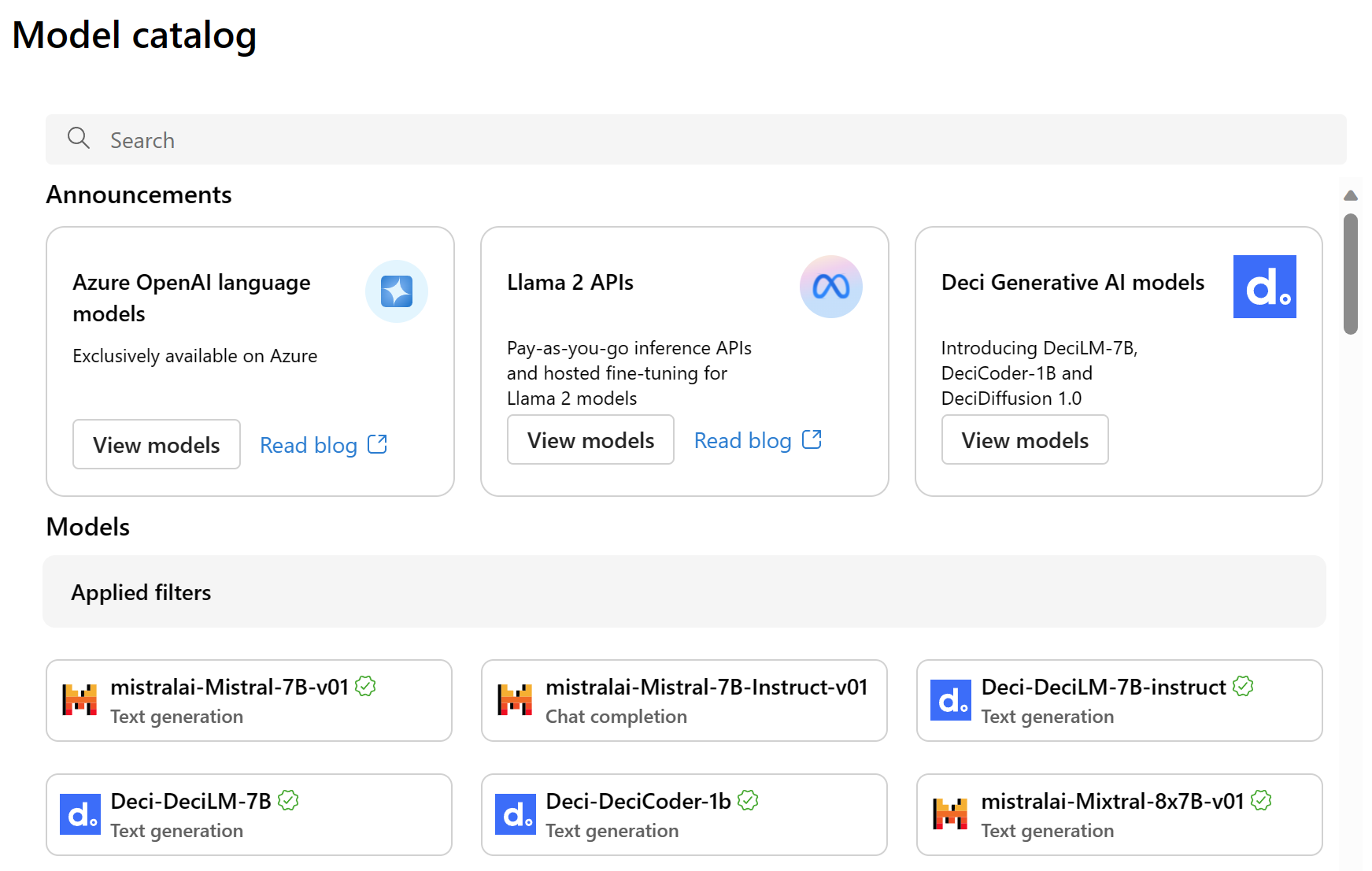

Per questo motivo Microsoft Azure ha creato un nuovo portale, raggiungibile all'indirizzo https://ai.azure.com/ che ci permette di creare progetti, sfruttare i modelli, testarli ed effettuare il deployment. In questo portale di recente è stata ampliata la sezione dedicata ai modelli, introducendo anche quelli di terze parti.

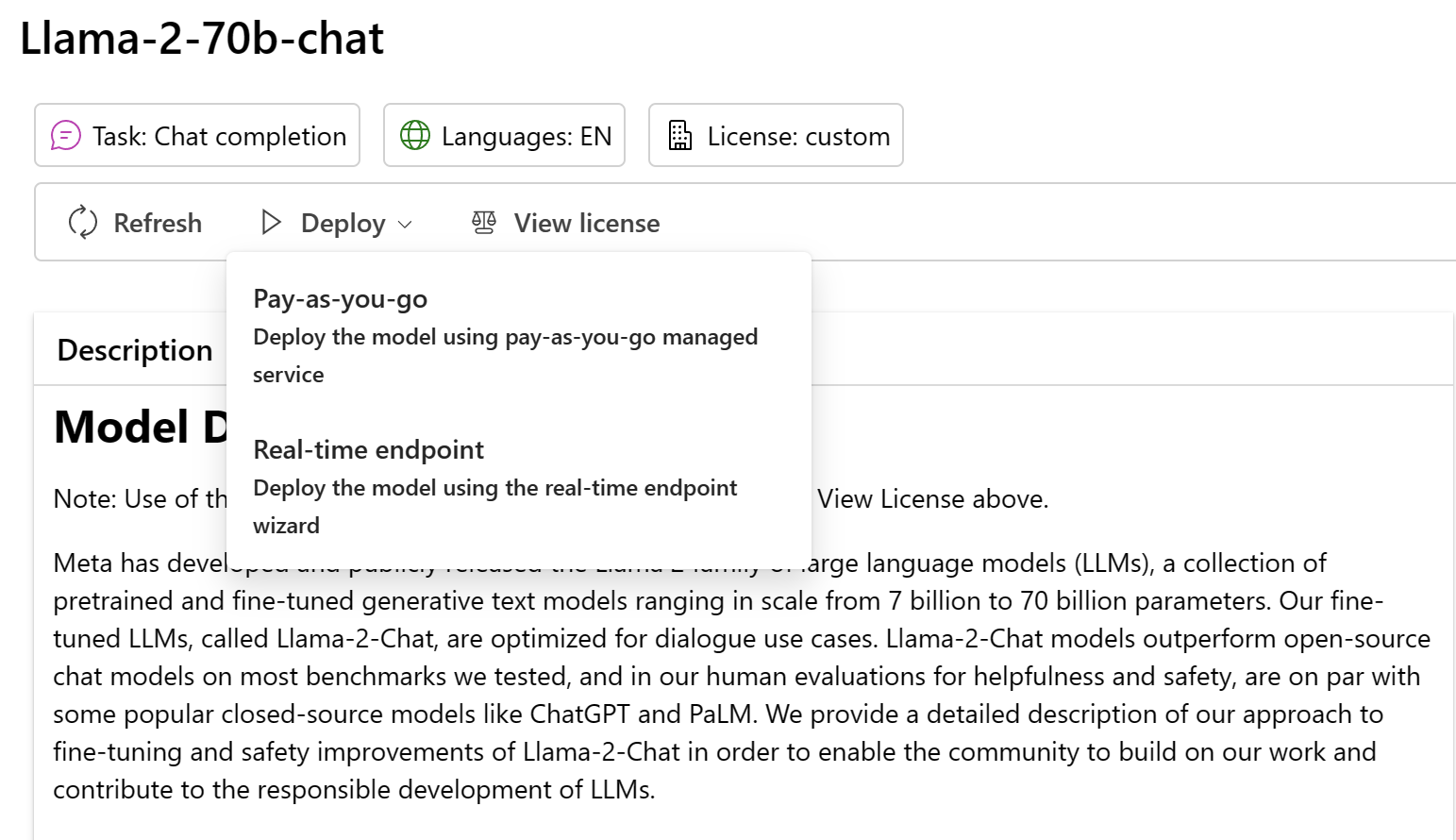

L'idea è che Microsoft Azure possa ospitare questi modelli fornendo un endpoint REST facile da utilizzare, delegando il resto alla piattaforma. Troviamo di conseguenza modelli open source, come Llama, oppure quelli offerti da Mistral AI. Entrando in uno di questi modelli, a seconda della tipologia di cui necessitiamo, possiamo effettuare il deploy.

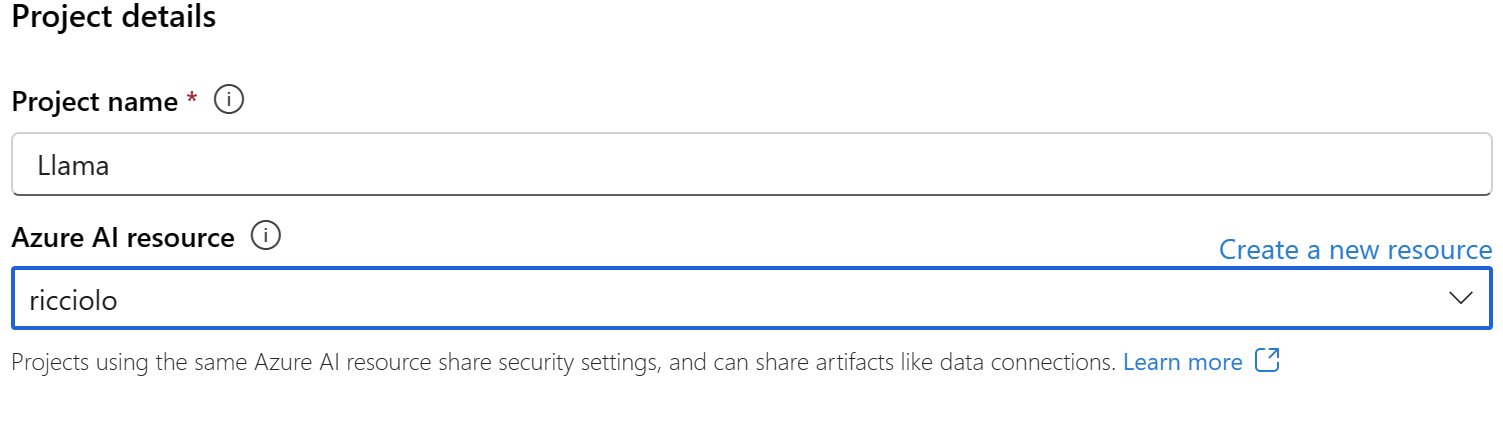

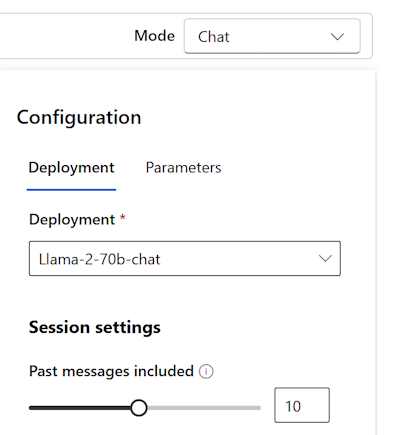

Possiamo farlo con una Virtual Machine dedicata, molto costosa ma dalle ottime prestazioni, oppure con un approccio pay-as-you-go (non supportato da tutti i modelli). Con Llama, per esempio possiamo proseguire con il deployment del modello Llama-2-70b-chat e seguire i vari passaggi. Prima di tutto va creato un progetto, poi applicata la risorsa Azure.

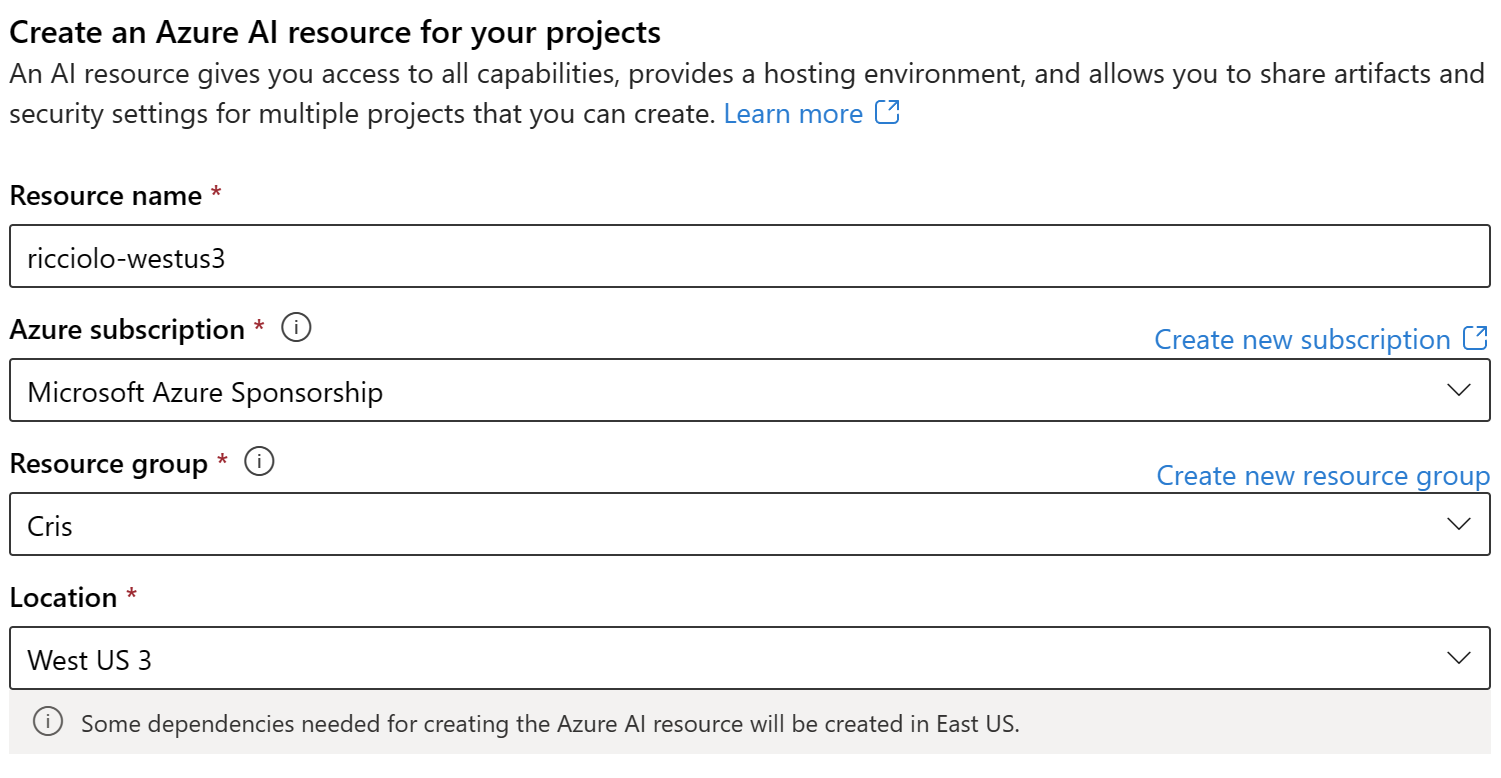

Se non disponiamo di una risorsa la possiamo creare, facendo attenzione alla posizione geografica che determina la disponibilità dei modelli (per ora West US 3 è tra i più completi).

Completato il wizard otteniamo il progetto e il deployment del modello scelto. Possiamo a questo punto entrare nel playground e selezionare il modello per provarlo direttamente dal portale.

Come per i modelli di OpenAI possiamo sfruttare l'endpoint HTTP per effettuare le richieste dal nostro codice.

Commenti

Per inserire un commento, devi avere un account.

Fai il login e torna a questa pagina, oppure registrati alla nostra community.

Approfondimenti

Creare un webhook in Azure DevOps

Ricevere notifiche sui test con Azure Load Testing

Usare i servizi di Azure OpenAI e ChatGPT in ASP.NET Core con Semantic Kernel

Migliorare la sicurezza dei prompt con Azure AI Studio

.NET Aspire per applicazioni distribuite

Escludere alcuni file da GitHub Secret Scanning

Gestione dell'annidamento delle regole dei layer in CSS

Il nuovo controllo Range di Blazor 9

Utilizzare la funzione EF.Parameter per forzare la parametrizzazione di una costante con Entity Framework

Utilizzare il metodo Index di LINQ per scorrere una lista sapendo anche l'indice dell'elemento

Gestione dei nomi con le regole @layer in CSS

Rendere le variabili read-only in una pipeline di Azure DevOps