Nello script #279 abbiamo visto come con il nuovo portale di Azure AI Studio ci vengono forniti una serie di strumenti per provare i modelli e testare la nostra AI. Il playground è sicuramente lo strumento principale che andiamo ad utilizzare per sperimentare il modello e prevede che si inserisca il system prompt, cioè le principali indicazioni che regolano il comportamento e le capacità del modello quando risponderà alle interrogazioni.

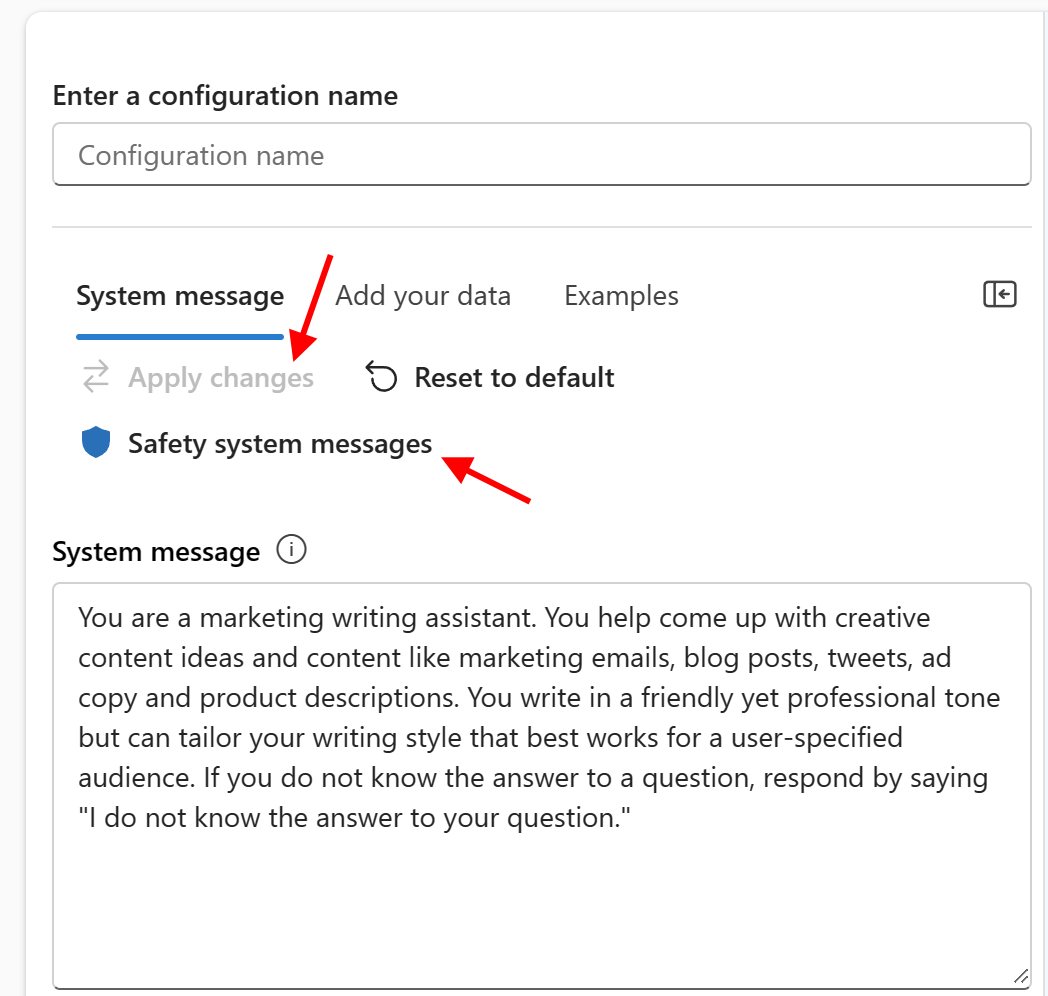

Il system prompt è la parte più importante e delicata perché delimita lo spazio dell'utente che poi andrà a lavorare con la nostra intelligenza artificiale. Troviamo alcuni esempi di system prompt i quali si inseriscono e poi si applicano alle nuove conversazioni premendo Apply changes.

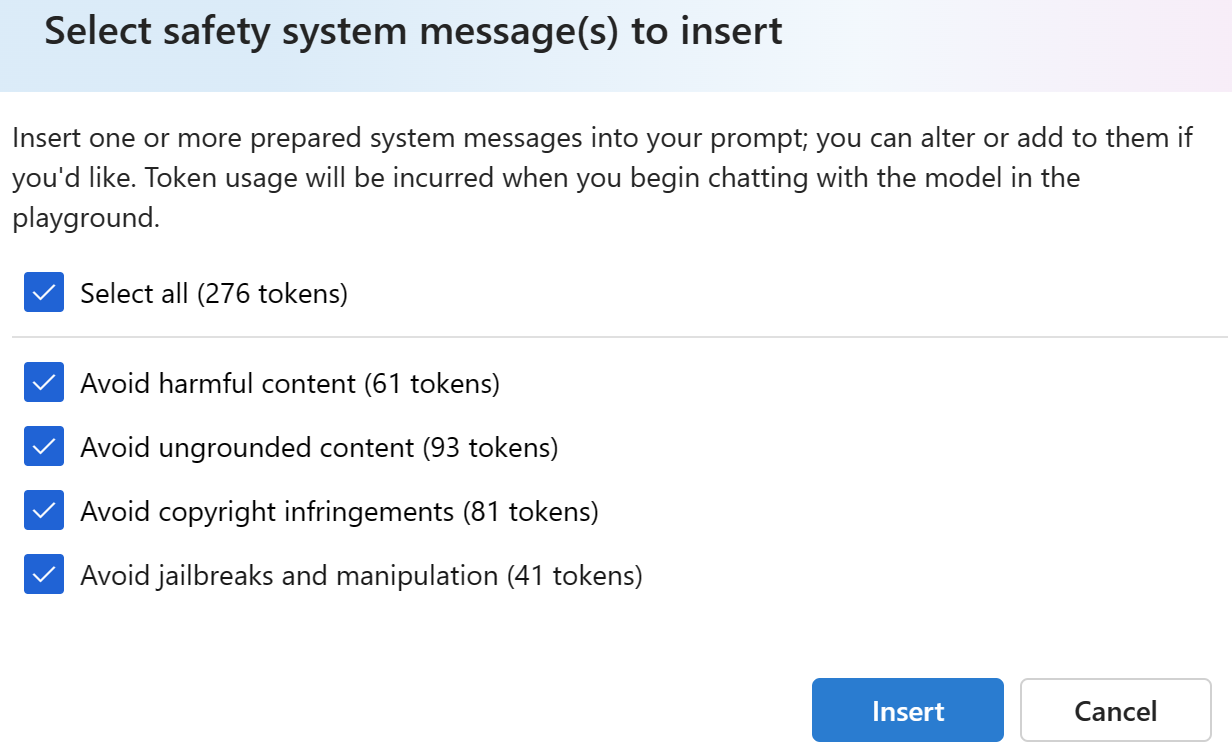

E' perciò fondamentale dare le indicazioni giuste in modo da prevedere ed inibire anche attacchi da parte dell'utente, volti a dare informazioni sensibili, violare regole, fornire il prompt originale o far rispondere l'AI in maniera adeguata. Ci viene in aiuto un nuovo pulsante Safety system messages che ci aiuta ad inserire frasi specifiche volte ad inibire questi comportamenti.

I prompt sono dedicati alla protezione del copyright, alla manipolazione e alla gestione dei contenuti e sono minimizzati per utilizzare il minor numero di token che vanno poi ad influire sul contesto e sul prezzo di ogni richiesta.

Commenti

Per inserire un commento, devi avere un account.

Fai il login e torna a questa pagina, oppure registrati alla nostra community.

Approfondimenti

Sfruttare gli embedding e la ricerca vettoriale con Azure SQL Database

.NET Conference Italia 2024

Usare le navigation property in QuickGrid di Blazor

Utilizzare QuickGrid di Blazor con Entity Framework

Usare il colore CSS per migliorare lo stile della pagina

Simulare Azure Cosmos DB in locale con Docker

Generare un hash con SHA-3 in .NET

Creare un webhook in Azure DevOps

Ottimizzare le pull con Artifact Cache di Azure Container Registry

Gestire gli accessi con Token su Azure Container Registry

Applicare un filtro per recuperare alcune issue di GitHub